Il professore americano B.F. Skinner ha dedicato gran parte della sua vita accademica, in qualità di professore di psicologia all’Università di Harward, a comprendere le influenze esterne che alcuni rinforzi possono avere sul nostro comportamento. La scienza comportamentale è una componente essenziale della gamification che, come sappiamo, ha il difficile compito di alterare i comportamenti degli utenti spostandoli da un punto A (sfera di interesse personale) ad uno B (sfera interesse esterna).

Onde prevenire critiche, ribadisco che la gamification a mio modo di vedere è una scienza agnostica che ha il dovere di far propria la parte migliore della elaborazione teorica per poi asservirla agli obiettivi che il progetto di volta in volta si pone. Guardo con disincanto teorie a volte contrastanti (si è parlato della self determination theory di Deci) ma che hanno comunque il merito di apportare alcuni set da traslare nel quotidiano.

Lo studioso americano fu il primo ad introdurre il concetto di “Operant Conditioning”, un metodo che aiuta i processi di apprendimento attraverso l’utilizzo di premi e punizioni. Una stretta relazione si instaura tra un nostro comportamento ed una conseguenza che esso comporta, una esaltazione delle motivazioni estrinseche che ci indurrebbero a compiere azioni in contrapposizioni a volontà innate (intrinsic motivation).

Guardandoci intorno questo è il paradigma regnante in strutture come quella lavorativa in cui incentivi vengono erogati per favorire l’insorgenza o il miglioramento di un dato comportamento: alla promessa di un premio produttività, il numero di bulloni realizzati potrebbe aumentare. In altri casi è possibile scoraggiare un comportamento attraverso una punizione o cessazione di un premio: sarai licenziato se continuerai ad arrivare dopo le 9 in ufficio.

Ma torniamo al nostro professore vissuto tra il 1909 ed il 1990, autore negli anni 30 del celeberrimo esperimento denominato “Skinner Box”.

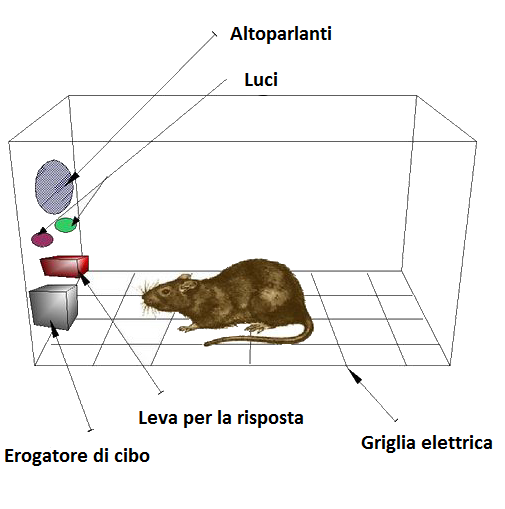

Un topo (ma anche piccioni) venne inserito in una specifica gabbia allo scopo di insegnargli specifiche azioni, come premere una leva, in risposta a determinati stimoli (luci e suoni). Se l’azione viene perfettamente eseguita, l’animale ottiene cibo o in generale un rinforzo dispensato dall’erogatore apposito. In alcuni casi la mancata o sbagliata esecuzione dell’azione portava ad una piccola scarica elettrica di punizione.

Teoricamente è possibile insegnare un comportamento ad un essere umano ed incentivarne la ripetizione verso un numero sempre maggiore di volte. Il premio offerto sarà dapprima associato ad ogni azione compiuta e nel tempo potrà diradarsi fino a scomparire continuando a generare ugualmente quel dato comportamento. Al fianco dei rinforzi positivi (o premi) si collocano i rinforzi negativi caratterizzati dall’evitare l’insorgenza di un qualcosa di negativo. Negli esperimenti Skinner poteva chiedere al topo di pigiare la leva per evitare una scarica elettrica. Se invece la scarica elettrica fosse diretta conseguenza della mancata azione si parla di Punizione.

L’osservazione diretta ha portato alla definizione di un “Reward Schedules” i cui principi sono già ampiamente utilizzati nel behavioural design e nella gamification attraverso un framework composto da tre fasi: contingenza, risposta e rinforzo. La contingency è il set di regole alla base del premio che andremo ad erogare all’espletamento di una certa azione. La risposta è il comportamento utente alla luce di questo condizionamento. Il rinforzo è, ovviamente, il premio dato alla corretta esecuzione dell’azione.

Continuous Reinforcement (CR): Il rinforzo continuo porta ad un premio ogni qual volta il topo spinge la leva. L’apprendimento di un nuovo comportamento è sempre supportato da un rinforzo. E’ uno strumento potentissimo in fase iniziale favorendo l’insorgenza di un behaviour attraverso una continua gratificazione. La sua curva di apprendimento è estremamente veloce al pari della sua estinzione. Per estinzione si intende la decadenza di tale comportamento una volta che il reward viene a cessare.

In un prodotto gamificato l’utilizzo di CR può portare nel brevissimo periodo all’esecuzione isterica dei task da noi programmati (inserire voti, commentare, cliccare…). L’effetto diventa nulla nel medio periodo e addirittura controproducente nel medio/lungo quando il premio sarà ormai considerato parte integrante dell’offerta. Ad equiparazione avvenuta la rimozione del reward continuo porterà ad un allontanamento dell’utente che ormai considerava proprio e dovuto quel meccanismo. Un esempio classico è quello legato alla spedizione gratuita elargita da alcuni siti di e-commerce. Inizialmente concepita come strumento di fidelizzazione momentaneo è finita per diventare parte insopprimibile dell’offerta e fonte di abbandono al mutare delle condizioni, ad esempio spedizione gratuita solo oltre i 100 euro di spesa o in particolari periodi. Il modus operandi ottimale è aiutare inizialmente l’insorgenza di un comportamento utente attraverso rinforzo continuo per switchare velocemente (e qui l’esatta collocazione temporale sarà basilare) verso un reward intermittente.

Ratio Schedules (RS): Lo schema razionale porta ad un premio dopo un certo numero di volte che il topo spinge la leva. Può essere una ratio prestabilita (ogni 10 volte si preme la leva si ottiene il cibo) ed in questo caso si parla di Fixed Ratio oppure una ratio variabile (ottiene il cibo dopo un numero di azioni non standardizzate) ed in questo caso si parla di Variable Ratio.

Fixed Ratio Schedules è uno schema caratterizzato da una curva di apprendimento veloce, sebbene non ai livelli del CR, e da un tasso di partecipazione alta ma non lineare. Una idea ce la possiamo fare analizzando i normali programmi di fidelizzazione al supermercato. Raggiunti 1000 punti accumulati tramite spesa si ottiene un set di tazzine. La frequency di questo programma di fidelizzazione sarà via via più alto all’approssimarsi dell’obiettivo con un picco negativo subito dopo la sua erogazione. Qualcosa di analogo avviene nella pizzeria con consegna a domicilio da cui mi rifornisco. Stampato sul cartone vi è un buono, raggiunti 10 si ha diritto a scegliere una pizza omaggio.

Il vantaggio di questo schema prestabilito consiste nella sua facilità di esecuzione e nel buon rapporto curva di apprendimento/tasso di utilizzo. A differenza del premio continuo, qui il comportamento è favorito attraverso premi cadenzati nel tempo che non diventano connaturati all’atto di acquisto. Anche qui i rischi non mancano, calibrare male può portare ad un tasso di abbandono molto alto. Se la pizza gratis arrivasse solo dopo 100 ordinazioni difficilmente mi sentirei motivato a conservare i coupon e basterebbe un competitor con una ratio migliore (ed ovviamente eguale qualità del prodotto) per cambiare fornitore.

Variable Ratio Schedules è uno schema caratterizzato da una curva di apprendimento medio/bassa ma in grado di generare un livello di engagement e fidelizzazione straordinaria con una estinzione molto lenta. Per capirci subito questo è lo schema utilizzato nelle slot machine ed in gran parte dell’industria del gambling. La dipendenza viscerale che molti individui hanno verso queste macchine è dovuta alla casualità della vincita, nessuno è in grado di prevedere quando il jackpot sarà deliverato. Qualcuno potrà vincere tirando la leva una sola volta nella slot machine ed ad altri potrebbero occorrere 20 tentativi, il tutto all’interno di un contesto garantito in cui un certo tipo di montepremi viene ridistribuito giornalmente. Il rischio di questa implementazione è bel bloccare l’esplorazione dell’utente/giocatore il cui cervello tenderà ripetutamente a compiere questa data azione dimenticandosi le restanti sezioni.

Trackbacks/Pingbacks